El desarrollo de robots y máquinas cada día más complejos hace inevitable la

pregunta ¿deberíamos implementar una ética para robots?

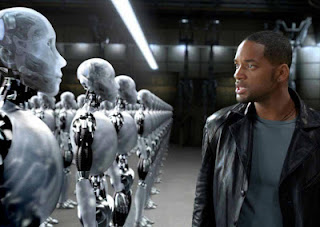

La ficción

es una inspiración para la vida. La ciencia ficción lo es para la ciencia. Gran

parte de los avances que vemos y veremos han sido precedidos por las visiones de

los escritores. Un ejemplo notable son las tres leyes de la robótica de Isaac Asimov, formuladas en

1942.

- Un robot no puede hacer daño a un humano.

- Un robot obedecerá las órdenes humanas, a menos que estas contradigan la primera ley

- Un robot protegerá su propia existencia excepto si esto entra en conflicto con la primera y segunda ley

Resulta curioso lo visionario y a la vez ingenuo que

resultaba Asimov. En un sentido, ya prevé robots autónomos, cosa que ahora

empezamos a ver. Es ingenuo porque los robots que estamos empezando a fabricar

están en buena medida diseñados para matar.

Cada día se diseñan y construyen nuevos robots. Pulgas que graban, arañas

espías o cruadricópteros.

Los drones del ejercito americano ya no solo realizan misiones de vigilancia.

Van cargados con mortíferas bombas. Los trenes sin conductor

proliferan. El vehículo autónomo está a punto de invadir nuestras calles.

El punto de inflexión es el momento en que estas máquinas sean

autónomas. Los drones están teledirigidos. Un humano

decide el objetivo y el momento. Pero como sabemos, cuando los dispositivos se

multiplican, su control desborda a los operadores y acaban siendo dotados de

autonomía. Un ejemplo de ello es el coche autónomo. Ningún humano lo

supervisará. Incluso diseñados para matar, los robots pueden tener

alguna ventaja: no tienen odio ni deseo de venganza, no cometen violaciones no

toman decisiones en caliente. Una característica de los soldados es el abuso

añadido a su función principal.

En la vida te planteas permanentemente problemas éticos. También cuando

conduces, aunque la reacción sea automática. Un niño se cruza, ¿freno? Un perro

se cruza ¿freno? Si freno, pongo en riesgo la vida de mi familia que me

acompaña. O la del coche de al lado. ¿Cuál es la opción moral adecuada? Si

desarrollamos un coche autónomo, ¿debería tener moral? Y cualquier otro robot autónomo, ¿debería

llevar implantado un módulo moral?

La moral humana es un vidrioso campo en el que las reglas no están en

absoluto claras. Esto se pone de manifiesto en los llamados dilemas

morales. Imagina que un tren avanza hacia un grupo de personas que

morirán aplastadas por él. Tú puedes cambiar el curso de los acontecimientos. Si

aprietas un botón, el tren cambiará de vía y aplastará a una única persona que

está en la nueva vía de forma que salvarías a cinco pero una moriría. ¿Lo

harías? Ahora imagina que las mismas personas están amenazadas pero a tu lado se

encuentra un individuo malencarado, sucio y con aspecto ebrio. Si lo empujas a

la vía, morirá atropellado, el maquinista parará el tren y las otras cinco

personas se salvarán. ¿Lo empujarías?

La mayoría de las personas responden que sí apretarían el botón causando la

muerte de una persona para salvar a otras cinco. La mayoría responde que no

empujaría al individuo malencarado, salvándolo y causando la muerte de los

cinco. Una explicación consiste en que en el primer caso manipulas un botón,

algo sin vida y en el segundo caso manipulas directamente a una persona.

Para implantar un modelo en un ordenador tienes que tener claro el

modelo. Para implantar ética en un robot, tienes que tener

clara la ética. Miles de leyes han sido necesarias para la convivencia humana

porque unas simples reglas éticas no sirven. ¿Cómo implementar

en los robots algo que no está claro en los humanos?

Hoy por hoy solo encontramos respuestas en la bendita ciencia

ficción.